En el contexto de la inteligencia artificial (IA), accuracy o exactitud es una medida de rendimiento.

Indica qué tan correctamente un modelo ha realizado su tarea en problemas de clasificación.

Se refiere a la proporción de predicciones correctas entre el total de predicciones realizadas.

En otras palabras, mide la cantidad de casos en los que el modelo acierta.

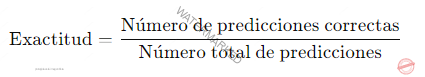

La fórmula básica de la exactitud es:

Un modelo está diseñado para clasificar si una imagen contiene un gato (positivo) o no (negativo).

Después de hacer varias predicciones, se evalúan los resultados comparándolos con las etiquetas verdaderas.

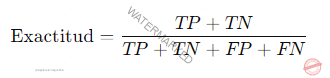

Los resultados pueden clasificarse en cuatro categorías:

Verdadero positivo (TP)

El modelo predijo «gato» y realmente había un gato en la imagen.

Verdadero negativo (TN)

El modelo predijo «no gato» y en realidad no había un gato en la imagen.

Falso positivo (FP)

El modelo predijo «gato», pero no había un gato en la imagen.

Falso negativo (FN)

El modelo predijo «no gato», pero sí había un gato en la imagen.

Limitaciones del accuracy

Aunque la exactitud es una métrica fácil de entender, puede ser engañosa en casos de datos desequilibrados.

Si el conjunto de datos tiene muchas más instancias de una clase que de la otra.

Por ejemplo, 95% «no gato» y 5% «gato»

Un modelo que prediga siempre «no gato» tendrá una alta exactitud 95%.

Pero será ineficaz para detectar gatos.

Métricas complementarias

En situaciones donde los datos están desequilibrados o cuando la precisión es crítica para una clase específica.

Se utilizan otras métricas adicionales para tener una mejor evaluación del modelo.

Precisión (Precision): qué proporción de predicciones positivas fueron correctas.

Sensibilidad o Recall: qué proporción de los casos positivos reales fueron identificados correctamente.

F1-Score: una medida que combina precisión y sensibilidad.

Estas métricas proporcionan una visión más equilibrada del rendimiento del modelo en lugar de depender únicamente de la exactitud.