Diffusion Models (Modelos de Difusión) son una clase de modelos generativos.

Basados en procesos de difusión.

Utilizados en la generación de imágenes, audio.

Populares por su capacidad para generar contenido de alta calidad.

Aplicaciones Stable Diffusion, DALL·E y Imagen de Google.

¿Cómo funcionan los Modelos de Difusión?

Los modelos de difusión aprenden.

A generar datos sintéticos.

Invirtiendo un proceso de ruido.

Consta de dos fases:

Proceso de difusión (Forward Process)

Se añade ruido gaussiano progresivamente.

A una imagen o dato de entrenamiento.

Hasta convertirlo en un ruido puro.

Esto destruye gradualmente.

La estructura de los datos originales.

Proceso de denoising (Reverse Process)

Un modelo entrenado aprende a revertir este proceso.

Eliminando el ruido paso a paso.

Reconstruir la imagen original.

Generar nuevas imágenes sintéticas.

Analogía

Imagina que desenfocas una imagen poco a poco.

Hasta que solo queda ruido.

El modelo aprende a deshacer este desenfoque.

Para recuperar la imagen original.

Crear una nueva.

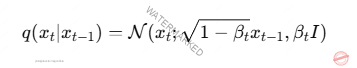

Ejemplo Matemático

Si representamos una imagen como x0

Proceso de difusión añade ruido en T pasos

Donde β es un parámetro.

Controla la cantidad de ruido en cada paso.

El modelo de IA aprende a revertir este proceso.

Generando nuevas imágenes.

A partir de ruido aleatorio.

Ejemplo práctico con Python Stable Diffusion y Hugging Face

Usando diffusers de Hugging Face

Generar imágenes con Stable Diffusion.

from diffusers import StableDiffusionPipeline

import torch

# Cargar el modelo preentrenado

pipe = StableDiffusionPipeline.from_pretrained(«runwayml/stable-diffusion-v1-5»)

pipe.to(«cuda») # Usa GPU para mejor rendimiento

# Generar una imagen a partir de un prompt

prompt = «Un castillo en la cima de una montaña, estilo fantasía»

image = pipe(prompt).images[0]

image.show()

¿Qué hace este código?

Descarga el modelo Stable Diffusion.

Usa una GPU para acelerar el proceso.

Genera una imagen a partir de un texto.

Ventajas de los Modelos de Difusión

Alta calidad

Genera imágenes con detalles realistas.

Más estables que GANs

Evitan problemas de entrenamiento.

El modo colapso.

Flexibilidad

Se pueden usar para diferentes tipos.

De datos imágenes, audio, texto.

Aplicaciones en IA

Generación de imágenes

Modelos como DALL·E y Stable Diffusion

Crean imágenes realistas a partir de texto.

Síntesis de audio

Modelos como AudioLM generan música y voz.

Reconstrucción de imágenes

Eliminación de ruido o restauración de imágenes antiguas.

Ciencia y simulaciones

Generación de estructuras moleculares.

Química computacional.

Futuro de los Modelos de Difusión

Optimización en tiempo de generación

Modelos más rápidos y eficientes.

Mejor control sobre la generación

Mayor personalización de imágenes y texto.

Aplicaciones en medicina y simulaciones científicas.

Los modelos de difusión son técnicas más avanzadas en IA generativa.

Su capacidad para crear contenido realista y detallado

Tecnologías en el ámbito de la generación.

Imágenes, audio y datos sintéticos.