¿Qué son los datos en la nube?

Los datos en la nube son información que no se guarda físicamente.

En tu ordenador o en dispositivos, sino en servidores que están en internet.

Es como guardar tus cosas en una «caja fuerte virtual»

Que puedes abrir desde cualquier lugar.

Dispositivo con conexión a internet.

¿Para qué sirven los Datos en la Nube?

Almacenar, acceder y compartir información.

De manera segura y conveniente.

No necesitas llevar un disco duro contigo.

Ni preocuparte por perderlo.

La nube te permite trabajar en equipo.

Varias personas pueden acceder y editar.

Documentos al mismo tiempo.

¿Cuáles son los usos de los Datos en la Nube?

Los usos son muy variados:

Almacenamiento

Fotos, vídeos, documentos, etc.

Google Drive o Dropbox.

Copias de seguridad

Si tu ordenador se daña, tus datos siguen seguros en la nube.

Colaboración

Equipos de trabajo pueden usar herramientas como Microsoft OneDrive

Google Docs para trabajar juntos en proyectos.

Aplicaciones en línea

Servicios como Netflix o Spotify funcionan gracias a la nube.

Análisis de datos

Empresas utilizan la nube para procesar grandes cantidades de información.

Automatización y Optimización de Flujos de Datos en la Nube AWS, Azure y GCP

Las empresas manejan grandes volúmenes de datos.

La automatización de flujos de datos en la nube permite escalar

Optimizar costos y mejorar el rendimiento.

¿Qué significa escalar un flujo de datos en la nube?

Un flujo de datos escalable es aquel que puede manejar más datos

Más usuarios sin degradar su rendimiento.

Escalabilidad vertical

Aumentar recursos en una sola máquina más CPU/RAM.

Escalabilidad horizontal

Agregar más máquinas para dividir la carga.

Clústeres distribuidos.

Ejemplo:

Una empresa de e-commerce pasa de 1,000 a 100,000 pedidos diarios.

Su pipeline de datos debe escalar.

Sin afectar el análisis de datos en tiempo real.

Implementación de flujos de datos escalables en AWS, Azure y GCP

Cada nube ofrece herramientas para construir.

Pipelines de datos automáticos y escalables.

AWS Amazon Web Services

AWS permite construir flujos de datos con servicios serverless

Almacenamiento escalable.

Ejemplo: ETL escalable en AWS con Glue y Redshift

AWS Glue → Extrae y transforma datos en la nube sin servidores.

Amazon S3 → Almacena datos crudos de forma escalable.

Amazon Redshift → Almacena datos estructurados para análisis.

Arquitectura

Los datos llegan en archivos CSV/JSON a S3.

AWS Glue limpia y transforma los datos.

Los datos limpios se cargan en Redshift.

Amazon QuickSight genera dashboards.

Código en AWS Glue (PySpark)

Beneficio: AWS Glue autoescala según el tamaño de los datos.

Azure Microsoft Azure

Azure permite construir pipelines de datos con Data Factory, Synapse y Databricks.

Ejemplo: Integración de datos en Azure

Azure Data Factory (ADF) → Orquesta pipelines de datos.

Azure Synapse Analytics → Data Warehouse escalable.

Azure Databricks → Procesamiento con Spark.

Arquitectura

Data Factory extrae datos desde SQL Server y APIs.

Databricks transforma los datos con Spark.

Synapse almacena los datos procesados.

Power BI visualiza los datos en dashboards.

Pipeline en Azure Data Factory

Beneficio: Data Factory permite mover datos sin escribir código.

GCP Google Cloud Platform

GCP es ideal para Big Data y Machine Learning con herramientas como BigQuery y Dataflow.

Ejemplo: Procesamiento de streaming en GCP con Dataflow y BigQuery

Cloud Pub/Sub → Recibe datos en tiempo real.

Dataflow (Apache Beam) → Procesa datos en streaming.

BigQuery → Analiza datos a gran escala.

Arquitectura

Eventos de usuario llegan a Pub/Sub en tiempo real.

Dataflow transforma los datos con Apache Beam.

BigQuery almacena los datos para consultas.

Looker Studio visualiza los insights.

Pipeline en Apache Beam (Dataflow)

import apache_beam as beam

# Definir pipeline

pipeline = beam.Pipeline()

# Leer datos en streaming desde Pub/Sub

datos = (pipeline

| ‘Leer de Pub/Sub’ >> beam.io.ReadFromPubSub(topic=’projects/mi-proyecto/topics/ventas’)

| ‘Decodificar JSON’ >> beam.Map(lambda x: json.loads(x))

| ‘Filtrar valores nulos’ >> beam.Filter(lambda x: x[‘precio’] is not None)

| ‘Transformar datos’ >> beam.Map(lambda x: {«cliente»: x[«cliente»], «monto»: float(x[«precio»])})

| ‘Escribir en BigQuery’ >> beam.io.WriteToBigQuery(«mi-proyecto.ventas.procesadas»)

)

# Ejecutar pipeline

pipeline.run()

Beneficio: GCP permite procesar datos en streaming en tiempo real.

Comparación entre AWS, Azure y GCP

| Característica | AWS | Azure | GCP |

| Orquestación | AWS Glue, Step Functions | Data Factory | Cloud Composer (Airflow) |

| Almacenamiento | S3 | Azure Blob | Cloud Storage |

| Procesamiento | EMR, Glue | Databricks | Dataflow |

| Data Warehouse | Redshift | Synapse | BigQuery |

| Streaming | Kinesis | Event Hub | Pub/Sub |

| Machine Learning | SageMaker | Azure ML | Vertex AI |

AWS es ideal para serverless ETL y automatización.

Azure es fuerte en integración con Microsoft Power BI, SQL Server.

GCP es la mejor opción para Big Data y Machine Learning.

Los flujos de datos automatizados

Permiten manejar datos sin intervención manual.

La nube ofrece escalabilidad

Eliminando la necesidad de infraestructura física.

Cada proveedor AWS, Azure, GCP

Tiene herramientas específicas según las necesidades.

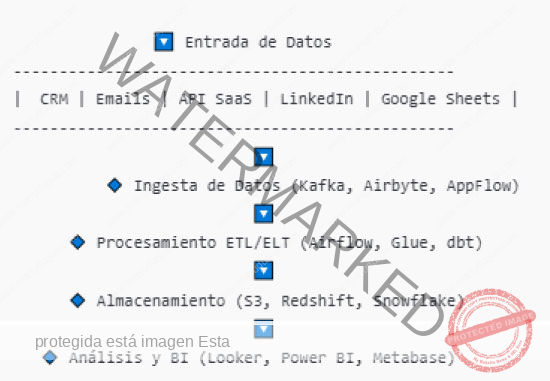

Arquitectura de Datos para un SaaS B2B

Objetivo:

Crear un pipeline de datos automatizado y escalable para:

Centralizar los datos de clientes y ventas.

Analizar el rendimiento de los SDRs.

Integrar con herramientas como CRM, email tracking y BI.

Diseño General de la Arquitectura

Entrada de datos → Procesamiento ETL/ELT → Almacenamiento → Visualización y análisis

Ingesta de Datos (Fuentes de Datos)

CRM HubSpot, Salesforce → Datos de clientes, interacciones y conversiones.

Herramientas de Email Tracking → Respuestas y aperturas de correos.

LinkedIn Sales Navigator/API → Información de leads.

Base de datos de producto → Actividad dentro del SaaS.

Google Sheets/API REST → Datos manuales o adicionales de clientes.

Herramientas: AWS AppFlow, Fivetran, Airbyte, Kafka.

Procesamiento ETL/ELT (Orquestación y Transformación de Datos)

ETL en tiempo real para analizar interacciones de SDRs en directo.

ELT batch para análisis históricos y métricas agregadas.

Transformaciones con dbt para modelado de datos en el Data Warehouse.

Herramientas:

Apache Airflow → Orquesta pipelines de datos.

AWS Glue o dbt → Transformaciones y limpieza de datos.

Apache Kafka → Streaming de eventos en tiempo real.

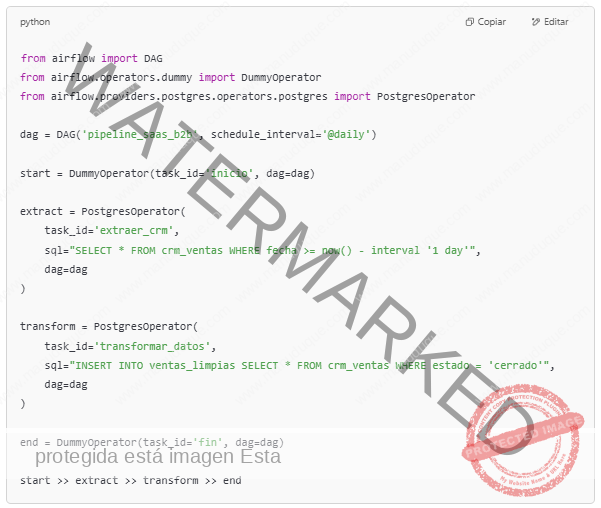

Ejemplo en Airflow:

Resultado: Automatiza la extracción y transformación diaria.

Almacenamiento y Data Warehouse

Data Lake (S3, GCS, Azure Data Lake) → Datos crudos y logs.

Data Warehouse (Snowflake, BigQuery, Redshift) → Datos limpios y listos para BI.

Base de datos operativa (PostgreSQL, MongoDB) → Datos en uso por el SaaS.

Ejemplo de modelo de datos en Snowflake (ventas de SDRs)

CREATE TABLE ventas_sdr (

id SERIAL PRIMARY KEY,

id_sdr INT,

cliente VARCHAR(255),

monto DECIMAL(10,2),

fecha TIMESTAMP

);

Resultado: Permite analizar ventas de SDRs en cualquier momento.

Visualización y Análisis de Datos

Looker / Power BI / Tableau → Dashboards para el equipo de ventas.

Metabase → Análisis interno.

Notebooks Jupyter, Google Colab → Análisis avanzado con Python.

Ejemplo de métricas a visualizar:

Conversión de leads

Métricas de SDRs (emails enviados, respuestas, cierres)

Ingresos generados por SDR

Beneficios de esta Arquitectura

Escalable → Maneja grandes volúmenes de datos sin problemas.

Automatizada → Reduce tareas manuales con Airflow y Glue.

Flexible → Soporta Batch y Streaming con Kafka.

Orientada a negocio → Genera dashboards accionables en Looker o Power BI.

Resumen Visual Arquitectura de Datos en AWS