Reinforcement Learning (RL) – Aprendizaje por Refuerzo (RL)

El Aprendizaje por Refuerzo (RL) es una técnica de aprendizaje automático.

Un agente aprende a interactuar con un entorno

Maximizar una recompensa acumulada.

Este enfoque se inspira en la forma en que los humanos.

Animales aprenden a través de prueba y error.

Recibiendo recompensas o castigos según sus acciones.

Elementos Clave del RL

Agente

El sistema que toma decisiones.

Basadas en observaciones del entorno.

Ejemplo:

Un robot que navega por una habitación.

Entorno

El mundo con el que el agente interactúa.

Ejemplo:

La habitación en la que se mueve el robot.

Estados (SSS)

Representación de la situación actual del entorno.

Ejemplo:

La posición actual del robot en la habitación.

Acciones (A)

Conjunto de decisiones disponibles para el agente.

Ejemplo:

Girar a la izquierda, avanzar, retroceder.

Recompensa (R)

Retroalimentación que recibe el agente.

Después de realizar una acción.

Ejemplo:

+1 por evitar una pared

-1 por chocar con ella.

Política (π\piπ)

Estrategia que utiliza el agente.

Decidir qué acción tomar en cada estado.

Ejemplo:

«Si estoy cerca de una pared, retroceder.»

Función de valor (V)

Estima el valor a largo plazo de estar en un estado particular.

Dado que se sigue una política específica.

Función de acción-valor (QQQ)

Estima el valor de realizar una acción específica.

En un estado particular.

Funcionamiento del Aprendizaje por Refuerzo

El agente sigue un proceso iterativo para aprender la mejor política.

Exploración

El agente experimenta con diferentes acciones.

Descubrir cuáles conducen a mayores recompensas.

Explotación

El agente aplica el conocimiento adquirido.

Maximiza la recompensa.

Retroalimentación

El entorno proporciona recompensas.

Según las acciones del agente.

Actualización

El agente ajusta su política y/o funciones de valor.

Basándose en la experiencia.

Técnicas en RL

Aprendizaje basado en modelos

El agente construye una representación interna.

Del entorno para planificar sus acciones.

Ejemplo:

Algoritmos como Model Predictive Control.

Aprendizaje sin modelo

El agente interactúa directamente con el entorno.

Sin construir un modelo explícito.

Ejemplo:

Q-Learning y Deep Q-Learning.

Métodos de valor

El agente aprende funciones de valor (V o Q)

Para tomar decisiones.

Ejemplo: Q-Learning.

Métodos de política

El agente aprende directamente una política óptima.

Sin usar funciones de valor explícitas.

Ejemplo: REINFORCE.

Métodos actor-crítico

Combina métodos de valor y política.

Un «actor» optimiza la política.

Un «crítico» evalúa las acciones.

Ejemplo:

Advantage Actor-Critic (A2C).

Algoritmos Clásicos de RL

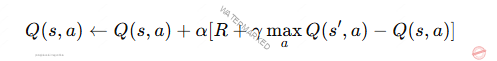

Q-Learning

Algoritmo sin modelo que actualiza la función.

De acción-valor (Q)

Aprende a través de exploración y actualización iterativa.

SARSA (State-Action-Reward-State-Action)

Similar al Q-Learning pero utiliza la acción seleccionada.

En el siguiente estado para la actualización.

Extiende Q-Learning usando redes neuronales profundas.

Aproximar la función Q

Manejando espacios de estado complejos.

Parámetros Importantes

Controla la velocidad con la que se actualizan los valores aprendidos.

Determina cuánto peso se da a las recompensas futuras.

En comparación con las inmediatas.

Balance entre exploración y explotación ϵ-greedy

Define cómo el agente equilibra probar nuevas acciones.

Explotar las conocidas.

Aplicaciones de RL

Robótica

Navegación autónoma, manipulación de objetos.

Videojuegos

Creación de agentes inteligentes.

Pueden jugar contra humanos.

Sistemas de recomendación

Optimización de recomendaciones adaptativas.

Finanzas

Gestión de carteras, optimización de inversiones.

Automóviles autónomos

Toma de decisiones en tiempo real.

Conducción segura.

Energía

Optimización de redes eléctricas.

Sistemas de energía renovable.

Ventajas y Limitaciones del RL

Ventajas

Toma de decisiones en entornos dinámicos y desconocidos.

Aprendizaje adaptable mediante prueba y error.

No requiere etiquetas para datos de entrenamiento.

Limitaciones

Requiere mucha interacción con el entorno.

Puede ser costoso.

El ajuste de hiperparámetros (α, γ, ϵ) puede ser complicado.

Puede ser ineficiente en espacios de estado grandes o continuos.

El Aprendizaje por Refuerzo es una herramienta para resolver problemas.

En la toma de decisiones secuenciales.

El uso de redes neuronales profundas en algoritmos como DQN.

Ampliado su aplicabilidad en campos complejos y dinámicos.

Te puede interesar;