Normalización de datos es un proceso en el que se ajustan los valores de las características (atributos).

De un conjunto de datos para que estén en un rango común.

Con ciertas propiedades estadísticas.

Este paso es esencial en muchos algoritmos de inteligencia artificial (IA).

Aprendizaje automático (ML).

Asegura que todas las características contribuyan equitativamente.

Al entrenamiento de los modelos.

Objetivos de la Normalización de Datos

Evitar el Dominio de Características

Asegurar que ninguna característica con valores grandes domine.

A otras con valores más pequeños.

Acelerar el Entrenamiento

Mejora la eficiencia de algoritmos optimizados mediante gradiente.

Redes neuronales y SVMs Máquinas de Vectores de Soporte.

Mejorar la Convergencia

Facilita la búsqueda de soluciones óptimas al reducir la complejidad numérica.

Preparar los Datos para Modelos Sensibles a Escalas

Algunos modelos como el KNN (k-Nearest Neighbors).

Algoritmos basados en distancia.

Son altamente sensibles a la escala de las variables.

Métodos de Normalización de Datos

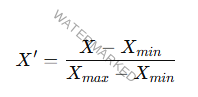

Min-Max Scaling

Escala los valores de cada característica al rango [0, 1]

A cualquier otro rango especificado.

Ventaja

Simple y útil cuando los datos tienen límites conocidos.

Desventaja

Sensible a valores atípicos.

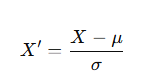

Z-Score Normalization (Estandarización)

Convierte los datos para que tengan media 0 y desviación estándar 1.

Ventaja

Útil cuando los datos siguen una distribución normal.

Desventaja

Más compleja de interpretar en términos de escala.

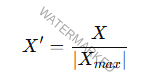

Normalización Máxima Absoluta

Divide cada valor por el valor absoluto máximo de la característica.

Ventaja

Conserva la dispersión relativa de los datos.

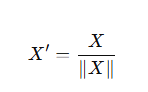

Escalado por Unidad de Norma (Normalization)

Escala los datos para que cada vector tenga una norma de magnitud igual a 1.

Ventaja

Común en técnicas basadas en similitudes, como modelos de texto.

Clipping o Recorte

Limita los valores dentro de un rango especificado.

Eliminando los valores extremos.

Importancia de la Normalización en IA

Modelos Basados en Distancias

Algoritmos como KNN, K-Means y SVM usan métricas de distancia.

Es crucial que las características tengan la misma escala.

Redes Neuronales

La normalización mejora la convergencia de algoritmos.

De optimización como SGD (Stochastic Gradient Descent).

Sensibilidad Numérica

Ayuda a mitigar problemas de precisión computacional.

En modelos que manejan grandes diferencias.

En las escalas de las variables.

Pasos para la Normalización de Datos

Inspección Inicial de los Datos

Analizar la distribución de cada característica.

Media, desviación estándar, rango, valores atípicos.

Selección del Método Apropiado

Elegir el tipo de normalización basado en la naturaleza del modelo y los datos.

Aplicación del Escalado

Usar bibliotecas como Scikit-learn para aplicar técnicas de normalización.

Validación

Asegurar que la normalización no introduzca sesgos.

Que los resultados del modelo mejoren después del ajuste.

Ejemplo Práctico

Caso: Clasificación de Clientes por Ingresos y Gastos

Problema

Los ingresos de los clientes están en miles de dólares.

Mientras que sus gastos mensuales están en cientos.

Solución

Normalizar los datos usando Min-Max Scaling

Para que ambos atributos estén en el rango [0, 1].

Impacto

Los modelos basados en distancia (KNN, SVM) tendrán un mejor rendimiento.

Ninguna característica dominará a la otra.

Ventajas de la Normalización de Datos

Mejor Desempeño del Modelo

Incrementa la precisión y reduce los errores en modelos sensibles a escalas.

Reducción de Sesgos

Asegura que cada característica contribuya equitativamente al modelo.

Facilidad de Interpretación

Los datos normalizados son más fáciles de interpretar visual y estadísticamente.

Desafíos de la Normalización

Impacto de Valores Atípicos

Algunos métodos como Min-Max Scaling son sensibles a valores extremos.

Requerimiento de Aplicación Consistente

Durante el entrenamiento y la predicción.

Es necesario aplicar la misma transformación a los datos.

Pérdida de Interpretabilidad

Los valores normalizados pueden ser menos intuitivos.

Herramientas para Normalización de Datos

Python

Librerías como Scikit-learn (MinMaxScaler, StandardScaler).

R

Paquetes como caret o funciones nativas.

Software de Análisis de Datos

Excel, RapidMiner, WEKA.

La normalización de datos es un paso crucial en la preparación de datos para IA y ML.

Asegura que los modelos puedan procesar las características.

De manera efectiva y equitativa.

Mejorando tanto la precisión como la eficiencia del análisis.

Aunque debe manejarse cuidadosamente para evitar problemas.

Con valores atípicos o pérdida de interpretabilidad.

La normalización es una herramienta indispensable.

Para trabajar con datos diversos y escalas variadas.

Te puede interesar;

Curso de ChatGPT: Todo lo que debes saber