DBRX es un modelo de lenguaje grande (LLM) de código abierto.

De uso general desarrollado por Databricks.

Se basa en una arquitectura de decodificador único.

Con Transformer y se entrenó utilizando la predicción del siguiente token.

Utiliza una arquitectura de mezcla de expertos (MoE)

Detallada con un total de 132 B de parámetros.

Características:

Modelo MoE

DBRX utiliza una arquitectura de expertos de mezcla fina MoE

Con 132B parámetros en total.

36B están activos en cualquier entrada.

Eficiencia

DBRX es más eficiente que otros LLM de tamaño similar.

Lo hace ideal para la implementación en producción.

Código abierto

DBRX está disponible bajo una licencia de código abierto.

Permite a los usuarios personalizarlo y mejorarlo.

Alto rendimiento

DBRX supera a los modelos de código abierto existentes.

A GPT-3.5 en los puntos de referencia estándar.

Aplicaciones

DBRX se puede utilizar para una amplia gama de aplicaciones.

De procesamiento del lenguaje natural (PLN)

Generación de texto

DBRX puede generar texto de alta calidad.

Resúmenes de texto, respuestas a preguntas.

Código, guiones y mucho más.

Traducción automática

Puede traducir texto de un idioma a otro.

Con precisión y fluidez.

Análisis de sentimientos

DBRX puede identificar el sentimiento de un texto.

Positivo, negativo o neutral.

Respuesta a preguntas

DBRX puede responder preguntas.

De manera precisa y completa.

DBRX es un LLM de código abierto y de uso general.

Con un alto rendimiento y una amplia gama.

De aplicaciones potenciales.

Herramienta que busca aprovechar el poder del PLN.

¿Qué es DBRX?

DBRX es un modelo de lenguaje grande (LLM) solo decodificador.

Basado en transformador mediante la predicción del siguiente token.

Entrenado previamente con tokens.

De 12T de texto y datos de código.

En comparación con otros modelos MoE abiertos.

Como Mixtral y Grok-1, DBRX es detallado.

Utiliza una mayor cantidad de expertos más pequeños.

DBRX tiene 16 expertos y elige 4.

Mixtral y Grok-1 tienen 8 expertos y eligen 2.

Proporciona 65 veces más combinaciones posibles de expertos

Mejora la calidad del modelo.

Utiliza codificaciones de posición rotatoria (RoPE).

Unidades lineales cerradas (GLU)

Atención de consultas agrupadas (GQA).

Utiliza el tokenizador GPT-4

Proporcionado en el repositorio de tiktoken.

Se basa en una evaluación exhaustiva y experimentos de escala.

Entrenado previamente en tokens de 12T de datos.

Seleccionados y una longitud de contexto máxima de 32k tokens.

Establece un nuevo estado para LLM abiertos establecidos.

Proporciona a la comunidad abierta.

Las empresas que crean sus propios LLM

DBRX supera a GPT-3.5 y es competitivo con Gemini 1.0 Pro

Superando a modelos especializados.

CodeLLaMA-70B en programación.

Solidez como LLM de propósito general.

Avanza por su arquitectura de mezcla de expertos (MoE).

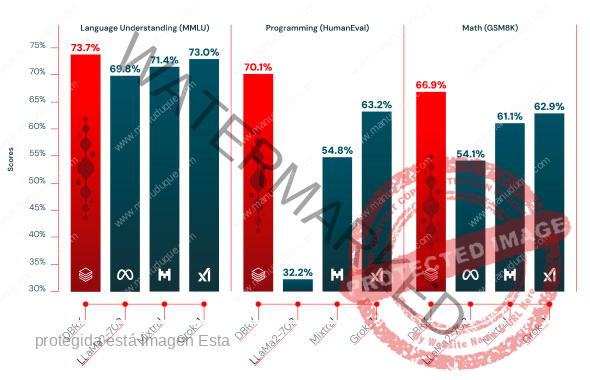

DBRX supera a los modelos de código abierto establecidos en comprensión del lenguaje (MMLU), programación (HumanEval) y matemáticas (GSM8K).

Fuente: Databricks

Solo acepta entradas basadas en texto.

Acepta una longitud de contexto de hasta 32768 tokens.

Descripción general del modelo

Es un modelo de lenguaje grande (LLM)

Solo decodificador basado en transformador.

Mediante la predicción del siguiente token.

Entrenado previamente en tokens de 12T de datos seleccionados.

Longitud de contexto máxima de tokens de 32K.

Son al menos 2 veces mejores token por token.

Que los datos que utilizamos para entrenar.

Previamente la familia de modelos MPT.

Se desarrolló utilizando el conjunto completo de herramientas.

Databricks, incluidos Apache Spark™ y cuadernos de Databricks

Procesamiento de datos, y Unity Catalog

Gestión y gobernanza de datos.

DBRX está disponible para que los clientes de Databricks lo utilicen a través de API.

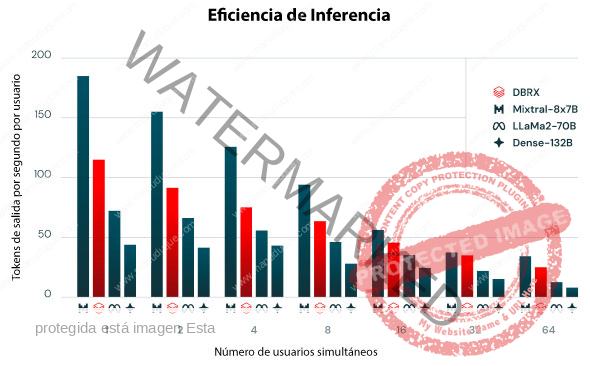

Rendimiento de inferencia para varias configuraciones de modelo en infraestructura de servicio optimizada utilizando NVIDIA TensorRT-LLM.

Con una precisión de 16 bits con los mejores indicadores de optimización que pudimos encontrar.

Los modelos se ejecutan en paralelo tensorial en todo el nodo.

El mensaje de entrada contiene aproximadamente 2000 tokens de mensaje y genera 256 tokens de salida. Cada segundo aparece un nuevo usuario.

Fuente: Databricks

Calidad de DBRX Instruct y modelos abiertos líderes.

| Model | DBRX Instruct | Mixtral Instruct | Mixtral Base | LLaMA2-70B Chat | LLaMA2-70B Base | Grok-11 |

| Open LLM Leaderboard2

(Avg of next 6 rows) |

74.5% | 72.7% | 68.4% | 62.4% | 67.9% | — |

| ARC-challenge 25-shot | 68.9% | 70.1% | 66.4% | 64.6% | 67.3% | — |

| HellaSwag 10-shot | 89.0% | 87.6% | 86.5% | 85.9% | 87.3% | — |

| MMLU 5-shot | 73.7% | 71.4% | 71.9% | 63.9% | 69.8% | 73.0% |

| Truthful QA 0-shot | 66.9% | 65.0% | 46.8% | 52.8% | 44.9% | — |

| WinoGrande 5-shot | 81.8% | 81.1% | 81.7% | 80.5% | 83.7% | — |

| GSM8k CoT 5-shot maj@13 | 66.9% | 61.1% | 57.6% | 26.7% | 54.1% | 62.9% (8-shot) |

| Gauntlet v0.34

(Avg of 30+ diverse tasks) |

66.8% | 60.7% | 56.8% | 52.8% | 56.4% | — |

| HumanEval5

0-Shot, pass@1 (Programming) |

70.1% | 54.8% | 40.2% | 32.2% | 31.0% | 63.2% |

Fuente: Databricks

DBRX Instruct se entrenó con una ventana de contexto de token de hasta 32 KB.

DBRX Instruct funciona mejor que GPT-3.5 Turbo en todas las longitudes de contexto y en todas las partes de la secuencia.

El rendimiento general de DBRX Instruct y Mixtral Instruct es similar.

Una de las formas más populares de aprovechar el contexto.

De un modelo es la generación aumentada de recuperación (RAG).

En RAG el contenido relevante para un mensaje se recupera de una base de datos.

Junto con el mensaje para brindarle al modelo.

Más información de la que tendría de otra manera.

Databricks apuesta por que cada empresa debería tener la capacidad.

De controlar sus datos y su destino en el mundo emergente de GenAI.

Fuentes: www.databricks.com